Wstęp

Jak wiadomo, wybór komponentów do komputera domowego lub służbowego jest bardzo złożonym problemem. Ktoś chce złożyć system o wysokiej wydajności, ktoś przede wszystkim martwi się poziomem hałasu, a ktoś po prostu chce zaoszczędzić pieniądze. W miarę naszych możliwości staramy się podawać nasze rekomendacje i potwierdzać je testami. Czasami jednak czytelnicy zadają nam tak wyszukane pytania, że bardzo trudno jest na nie odpowiedzieć bez dodatkowego przygotowania. W wyniku studiowania takiej tematyki pojawiają się niekiedy bardzo nietypowe opracowania, które jednak często wydają się nam bardzo interesujące dla szerszego grona czytelników. Dzisiaj chcielibyśmy opowiedzieć właśnie o badaniu kolejnego „subtelnego” pytania, nie ma tak wielu testów, które mogą pomóc w udzieleniu odpowiedzi, w ogromie globalnej sieci (jeśli w ogóle istnieją).

Wyobraź sobie więc komputer, który ma dość mocny (lub nawet flagowy) procesor centralny i wysokowydajny podsystem wideo, który może obsłużyć całe nałożone na niego obciążenie bez żadnych skarg. Jednak właściciel takiego komputera, zainspirowany nieoczekiwaną opłatą lub po prostu niezamierzonym impulsem myślowym, chce kontynuować modernizację swojego systemu. Na co przede wszystkim należy zwrócić uwagę w takiej sytuacji?

Ogólnie rzecz biorąc, jeśli anulujesz zmianę płyta główna, procesor i ulepszenie podsystemu wideo, to nie zostało już tak wiele opcji. Możesz poprzestać na zakupie jakichkolwiek urządzeń peryferyjnych, gadżetów lub innych powiązanych urządzeń. Ale możesz też poradzić sobie z „podrobami” komputera - podsystemem dyskowym lub pamięcią RAM. Właśnie na tych dwóch możliwościach chcielibyśmy się dzisiaj nieco bardziej szczegółowo zastanowić.

W większości przypadków usprawnienie podsystemu dyskowego lub podsystemu pamięciowego następuje nie w pogoni za wyższą wydajnością, ale z konieczności. Dane na dysku twardym przestały się mieścić - kupowany jest nowy. Systematyczne wywołania systemu operacyjnego do pliku wymiany zaczęły denerwować - głośność rośnie pamięć o swobodnym dostępie. Zaplanowane aktualizacje tych podsystemów, mające na celu wyłącznie poprawę ogólnej wydajności i szybkości komputera, należą do rzadkości. I zdarzają się one najczęściej tylko wtedy, gdy zakres użytkowania system komputerowy jest specyficzny, a szybkość pracy w konkretnym przypadku silnie zależy od któregokolwiek z tych podsystemów.

Na przykład jest dość oczywiste, że wydajność serwera plików lub systemu przetwarzającego duże ilości danych przechowywanych na dysku twardym można łatwo poprawić, wymieniając dysk na szybszy lub instalując macierz RAID. Tak jak komputer, na którym zwykle działa kilkanaście aplikacji intensywnie korzystających z zasobów, czy np. kilka maszyn wirtualnych, musi być wyposażony w odpowiednią ilość pamięci RAM, a zwiększenie jej wolumenu może poważnie zwiększyć szybkość i responsywność systemu. Są to jednak sytuacje dość oczywiste, a użytkownicy, których działania odbywają się w takich lub podobnych warunkach, nigdy nie zadają sobie pytania, co powinni w pierwszej kolejności zaktualizować – prawdopodobnie wiedzą wszystko bez naszej porady.

Inna sprawa, jeśli mówimy o typowym, powszechnie używanym systemie, który generalnie całkiem znośnie radzi sobie z wszelkimi powierzonymi mu zadaniami i nie wykazuje żadnych ewidentnych wąskich gardeł. W takim przypadku zaczynają pojawiać się pytania: co - podsystem dyskowy czy podsystem pamięci - czy w pierwszej kolejności bardziej racjonalne jest ulepszanie? Który z tych dwóch obszarów modernizacji da większy efekt praktyczny?

Wydawałoby się, że zainstalowanie szybszego dysku twardego jest bardzo rozsądną opcją. Co więcej, obecnie dostępne są w sprzedaży dość przystępne dyski półprzewodnikowe, które mają znacznie wyższą wydajność niż tradycyjne dyski magnetyczne. Nasza witryna, podobnie jak wiele innych źródeł informacji, oferuje ogromną ilość informacji na temat testowania różnych opcji dysków twardych, ale w większości przypadków są to wyniki dysków w testach syntetycznych. Jeśli chodzi o rzeczywiste aplikacje, to co najwyżej mierzony jest czas potrzebny do załadowania systemu operacyjnego lub niektórych wybranych „ciężkich” aplikacji. Należy jednak rozumieć, że ładowanie systemu operacyjnego i programów jest zdarzeniem jednorazowym, które zresztą jest przyspieszane przez nowoczesne systemy operacyjne dzięki proaktywnemu buforowaniu danych (na przykład w systemie Windows technologia ta nazywa się SuperFetch). I oczywiście szybki dysk SSD może przyspieszyć proces uruchamiania i zwiększyć responsywność systemu, skracając bolesne sekundy oczekiwania na uruchomienie programów i otwarcie plików, ale czy może zwiększyć wydajność codziennej pracy w typowych aplikacjach?

Aby odpowiedzieć na to pytanie, zmierzyliśmy szybkość realizacji typowych scenariuszy w systemie testowym wyposażonym w zasadniczo różniące się szybkością nośniki informacji. Innymi słowy, staraliśmy się zobaczyć wpływ twardy dysk nie na wynikach testów syntetycznych, ale na wydajności w tych testach, w których zwykle oceniamy ogólną wydajność systemów komputerowych.

Podobnie próbowaliśmy śledzić wpływ na Całkowita wydajność zwiększenie ilości pamięci RAM. W końcu dodatkowa pamięć dzięki technologii SuperFetch pozwala ograniczyć dostęp do dysku twardego, częściowo zastępując je interakcją z danymi buforowanymi w pamięci RAM. Dlatego na pierwszy rzut oka wydaje się, że zwiększenie ilości pamięci RAM może wywołać efekt podobny do efektu instalacji np. tego samego dysku SSD w systemie.

Testuj komponenty - dyski twarde i pamięć

Postanowiliśmy ocenić wpływ wyboru dysku twardego na ogólną wydajność systemu, wybierając do eksperymentów trzy zasadniczo różne dyski twarde:

wolny, energooszczędny dysk twardy firmy Western Digital należący do serii Caviar Green (WD20EARS);

nowy szybki dysk twardy 600 GB Western Digital VelociRaptor (WD6000HLHX) 10 000 obr./min z buforem 32 MB;

jeden z najpopularniejszych dysków SSD Intel X25-M G2 (SSDSA2MH160G2), zbudowany w oparciu o pamięć flash NAND 34 nm.

Z szczegółowe testy Możesz znaleźć te dyski w odpowiedniej sekcji naszej witryny, ale po prostu przypomnimy sobie ich charakterystykę prędkości za pomocą prostego syntetycznego testu CrystalDiskMark 3.0.

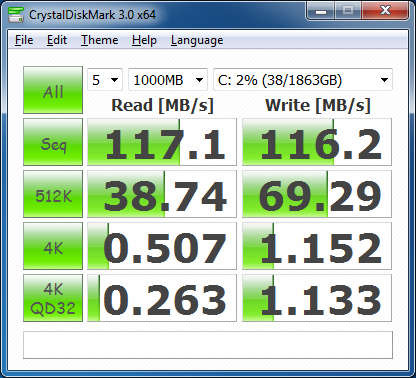

Western Digital Caviar Green (WD20EARS)

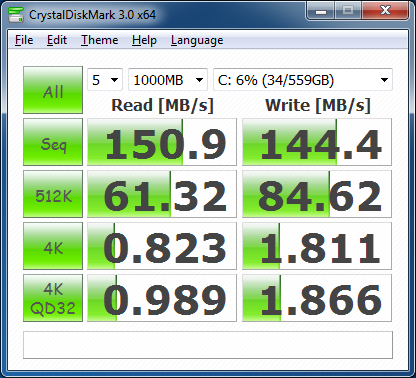

Western Digital VelociRaptor (WD6000HLHX)

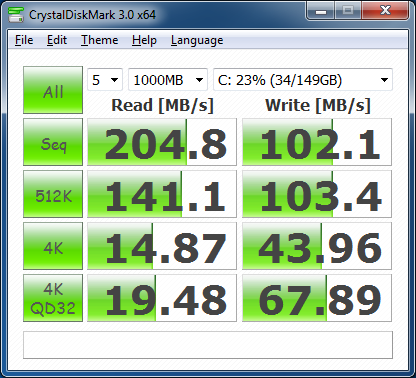

Intel X25-M G2 (SSDSA2MH160G2)

Jak widać, prędkość transmisji danych na tych trzech dyskach diametralnie się różni, mimo że wszystkie można zaliczyć do nowoczesnych. Nie jest to jednak zaskakujące - seria WD Green koncentruje się na oszczędzaniu energii i podbijaniu dużych wolumenów, dysk WD Velociraptor jest rekordzistą szybkości wśród napędów magnetycznych z Interfejs SATA, a Intel SSD to po prostu dobry i szybki pendrive NAND. W której dysk SSD jak można się spodziewać, prawie zawsze zostawia swoich konkurentów daleko w tyle, z wyjątkiem jednego przypadku - sekwencyjnego zapisu danych, a przy testowaniu szybkości pracy z losowymi blokami, jego prędkość przewyższa prędkość tradycyjnych dysków twardych dziesiątki razy. Napędy oparte na dyskach magnetycznych charakteryzują się również bardzo dużym rozrzutem parametrów, co w pełni koreluje z ich cechami konstrukcyjnymi – szybkością wrzeciona, gęstością zapisu oraz fizycznymi rozmiarami talerzy.

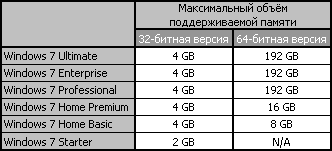

Jeśli chodzi o ilość pamięci RAM, to dziś de facto standardem dla typowych systemów desktopowych można uznać 4 GB. Oczywiście do pełnego wykorzystania tej ilości pamięci wymagana jest 64-bitowa wersja systemu operacyjnego, ale od dłuższego czasu nie stanowi to problemu. Z taką ilością pamięci RAM jest obecnie najpopularniejszy system operacyjny Microsoft Windows 7 czuje się najbardziej komfortowo, zwłaszcza jeśli jest wypchana różnymi oprogramowanie. Dlatego od co najmniej kilku lat wyposażamy systemy testowe w dwa moduły pamięci o pojemności 2 GB.

Tymczasem rozpowszechnianie 64-bitowych Wersje Windowsa 7 i pojawienie się w sprzedaży niedrogich, ale pojemnych modułów DDR3 SDRAM doprowadziło do tego, że wielu użytkowników, którzy myślą o modernizacji, jest moralnie gotowych na zwiększenie ilości pamięci RAM do 8 GB. Właściwie sam Windows 7 nie stwarza w tym żadnych przeszkód - każda z 64-bitowych modyfikacji tego systemu operacyjnego bez problemu obsługuje 8 GB pamięci RAM.

Tym samym przy korzystaniu z 64-bitowego systemu operacyjnego rozbudowa podsystemu pamięci do 8 GB nie sprawi żadnych trudności – potrzebne są jedynie odpowiednie do tego celu moduły. Korzyścią ze zwiększenia ilości pamięci RAM będzie to, że system operacyjny będzie rzadziej korzystał z dysku twardego, w wyniku czego system będzie działał szybciej. Innymi słowy, zwiększenie ilości pamięci RAM można również uznać za pośrednią metodę optymalizacji podsystemu dyskowego. Dlatego też, badając wpływ parametrów szybkościowych dysków na ogólną wydajność komputera, postanowiliśmy przyjrzeć się temu, co stanie się ze wzrostem ilości pamięci RAM.

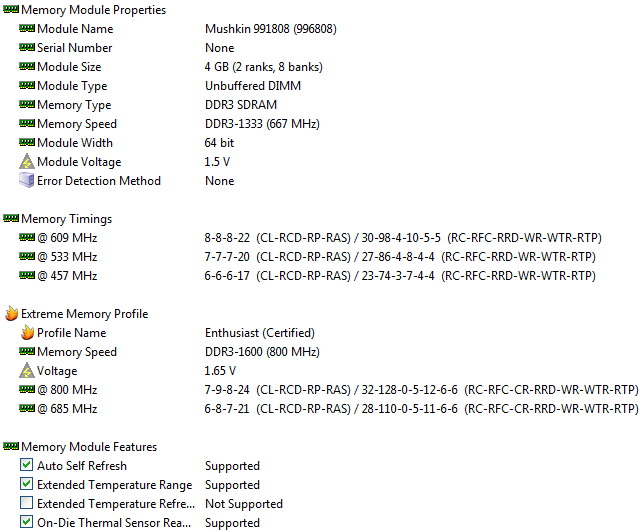

Obecnie wszyscy liczący się producenci pamięci dla entuzjastów są gotowi zaoferować zestawy składające się z par modułów 4 GB – ich stworzenie nie wymaga dużego nakładu pracy, skoro układy DDR3 SDRAM o pojemności 2 GB są w użyciu od dawna. Do tych testów taki zestaw modułów zaoferowała nam firma Mushkin, która wysłała do laboratorium pamięć DDR3-1600 o numerze artykułu 996808.

To para dwustronnych 4 GB modeli DDR3-1600 przeznaczonych do pracy z timingami 7-9-8-24 przy napięciu 1,65 V. timingi 6-8-7-21.

Moduły wyposażono w autorski system chłodzenia Ridgeback, składający się z aluminiowych płyt sąsiadujących z układami scalonymi oraz niewielkiego radiatora na górze. Wysokość tego projektu wynosi dokładnie 40 mm, czyli znacznie więcej niż w przypadku konwencjonalnych modułów pamięci.

Overclockerzy często traktują moduły o dużej pojemności z pewną nieufnością, ale w tym przypadku możliwości przetaktowywania zestawu Mushkin 996808 nie różnią się od możliwości zwykłych jednostronnych modułów 2 GB. Dlatego zainstalowanie większej ilości pamięci do przetaktowywania wydaje się godną opcją modernizacji systemu o wysokiej wydajności.

Jednak testy powinny pokazać, jak dobra jest ta lub inna opcja w praktyce. Przejdźmy do nich.

Opis systemu testowego

Do testów wykorzystano stanowisko o następującej konfiguracji:

Procesor: Core i7-870 (Lynnfield, 4 rdzenie/8 wątków, 2,93 GHz, 8 MB L3);

Płyta główna: ASUS P7P55D Premium (LGA1156, Intel P55 Express);

Pamięć:

2 x 2 GB, DDR3-1600 SDRAM, 9-9-9-27 (Kingston KHX1600C8D3K2/4GX);

2 x 4 GB DDR3-1600 SDRAM, 9-9-9-27 (Mushkin 996808);

Karta graficzna ATI Radeon HD 5870;

Dyski twarde:

Western Digital Caviar Green (WD20EARS);

Western Digital VelociRaptor (WD6000HLHX);

Intel X25-M G2 (SSDSA2MH160G2).

Chłodzenie procesora: Thermalright Ultra-120 eXtreme z wentylatorem Enermax Everest;

Zasilacz: Tagan TG880-U33II (880 W);

System operacyjny: Microsoft Windows 7 Ultimate x64;

Kierowcy:

Sterownik chipsetu Intel 9.1.1.1025;

Sterownik karty graficznej ATI Catalyst 10.9.

Wydajność

Ogólna wydajność — SYSmark 2007

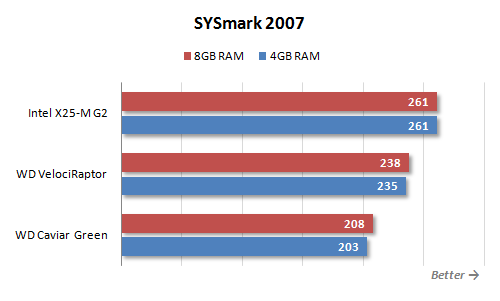

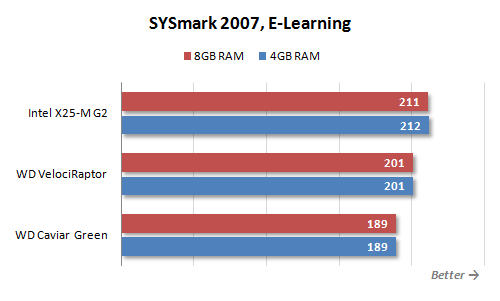

Testowanie w złożonych testach z wykorzystaniem rzeczywistych aplikacji najlepiej pasuje do naszych celów. Na przykład SYSmark 2007 - symuluje działania użytkownika podczas rozwiązywania różnych praktycznych problemów i próbuje odtworzyć naturalne obciążenie - otwiera kilka aplikacji jednocześnie, aktywnie przełącza się między nimi, przesyła dane za pomocą schowka.

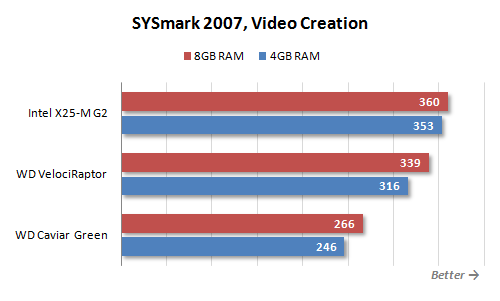

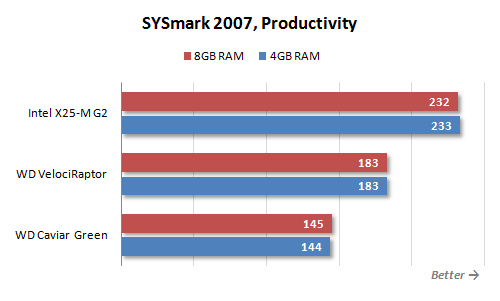

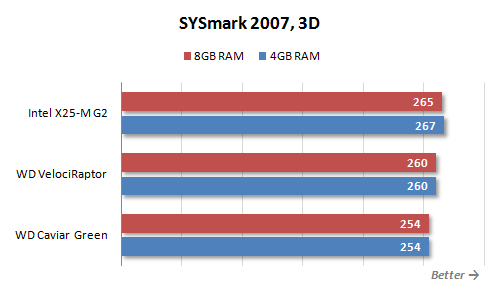

Jak widać z wyników, nie należy lekceważyć wpływu wyboru dysku twardego i rozmiaru pamięci na ogólną wydajność. Rozrzut wyników na wykresie sięga 25%, co oznacza, że w codziennej pracy wrażenia z pracy z systemem z szybkim dyskiem i zwiększoną pamięcią będą znacznie lepsze. Naturalnie przyspieszenie osiąga się przede wszystkim poprzez zmniejszenie opóźnień podczas operacji dyskowych. Widać to wyraźnie w „pośrednich” wynikach testu SYSmark 2007.

Największa zależność od szybkości podsystemu dyskowego przejawia się w scenariuszu Productivity. Jest to całkiem naturalne, w tym scenariuszu występuje typowa praca z Dokumenty Microsoftu Biuro i s e-mail. Nic dziwnego, tutaj użycie szybkiego dysku SSD daje 60-procentowy wzrost prędkości. Nie bez znaczenia jest również wpływ płyty na szybkość pracy z treścią cyfrową w scenariuszu Video Creation. Tutaj okazuje się, że jest taki przede wszystkim ze względu na włączenie do niego Adobe Photoshop, który intensywnie wykorzystuje dysk podczas przetwarzania dużych obrazów. Ale w scenariuszu 3D, w którym nacisk kładzie się na ostateczny rendering w pakietach do modelowania 3D, prędkość dysku nie odgrywa specjalnej roli, a moc obliczeniowa procesora ma ogromne znaczenie.

Jednocześnie wyniki testów z użyciem różnej ilości pamięci są nieco rozczarowujące. Jeśli zmiana dysków znacznie wpływa na odczyty SYSmark 2007, zwiększenie ilości pamięci RAM prowadzi tylko do niewielkiego wzrostu wydajności na ich tle. Co, nawiasem mówiąc, obserwuje się tylko w jednym scenariuszu - Video Creation, oczywiście z powodu tego samego Adobe Photoshop.

I wygląda to absolutnie przygnębiająco, że zwiększenie ilości pamięci do 8 GB może nawet doprowadzić do spadku wydajności - widzimy to w testach z dyskiem półprzewodnikowym. Oczywiście spadek wyniku jest nieznaczny, ale mimo to ma miejsce w wielu testach, mimo że Windows 7 wyłącza technologię SuperFetch, jeśli w systemie jest zainstalowany dysk SSD.

Praca z zawartością cyfrową — Intel HDxPRT 2010

Intel HDxPRT 2010 (Intel High Definition Experience & Performance Ratings Test) to kolejny kompleksowy test podobny do SYSmark 2007. Jeśli jednak SYSmark 2007 ma na celu określenie wydajności systemu podczas pracy w typowych aplikacjach, test Intel HDxPRT 2010 jest bardziej wyspecjalizowane. Jest przeznaczony do oceny wydajności systemu podczas typowych operacji dla użytkowników domowych w celu tworzenia, przetwarzania i odtwarzania treści cyfrowych. Wykorzystuje pakiet aplikacji do pomiaru wydajności, składający się z Cyberlink PowerDVD 9, Cyberlink PowerDirector 8, DivX Pro Codec 6.8.5, HDRsoft Photomatix 3, UnifiedColor HDR Photostudio v2.13.32, Adobe Odtwarzacz Flash v10.1, Apple iTunes 9.0.3 Adobe Photoshop Elements 8.0 i Windows Media Player 11. Test obejmuje trzy scenariusze: transkodowanie wideo HD nagranego kamerą, obróbkę zdjęć cyfrowych oraz przygotowanie plików audio i wideo do odtwarzania na przenośnych odtwarzaczach.

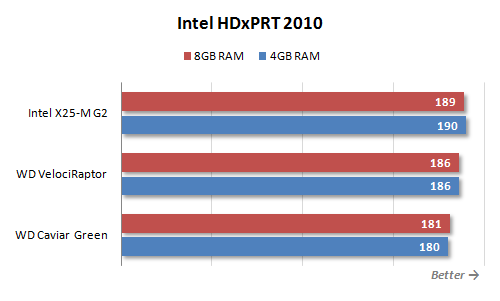

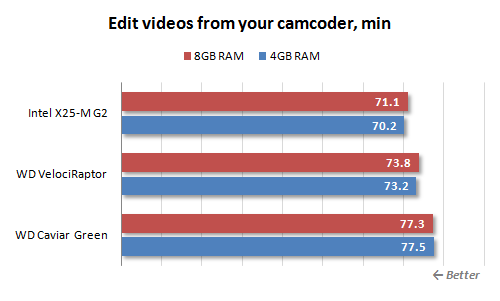

Widoczny jest tutaj również wpływ parametrów prędkości dysku, ale skala tego zjawiska, szczerze mówiąc, nie jest imponująca. Jest to jednak całkiem naturalne. Ten test dotyczy głównie plików multimedialnych o wysokiej rozdzielczości, a podczas ich przetwarzania wydajność jest ograniczona przez moc obliczeniowa, a nie w szybkości podsystemu dyskowego. Zwiększenie ilości pamięci RAM, sądząc po wynikach Intel HDxPRT 2010, nie daje żadnego efektu. Oczywiście typowa obróbka plików audio i wideo nie wymaga użycia więcej niż standardowe 4 GB RAM, zdjęcia wykonane nowoczesnymi aparatami cyfrowymi idealnie mieszczą się w tej ilości pamięci.

Ponowne uszczegółowienie wyników testu daje pewność, że praca z danymi multimedialnymi nie jest przypadkiem, w którym można osiągnąć imponujący efekt poprzez modernizację dysku twardego lub podsystemu pamięci.

![]()

Najważniejsze, jak widzimy, nie jest uciekanie się do korzystania z nadmiernie wolnych nośników pamięci. Tak więc różnica między szybkością działania skryptu przeznaczonego do edycji i transkodowania wideo w systemie z Western Digital Caviar Green, a systemem z dyskiem SSD sięga 10%, a to już jest dość namacalna różnica. Jednak w innych scenariuszach taka różnica nie jest nawet bliska.

Testowanie aplikacji

Pozytywny wpływ zastosowania szybkiego podsystemu dyskowego jest dość oczywisty, jeśli ocenimy szybkość ładowania aplikacji i danych z plików. Właściwie jest to zrozumiałe nawet bez dodatkowych testów, wystarczy spojrzeć na wyniki testów syntetycznych. Dlatego w ramach tego materiału staraliśmy się zrezygnować z takich prymitywnych pomiarów, a skupiliśmy się na testowaniu szybkości przetwarzania danych w tych zadaniach, w których szybkość podsystemu dyskowego może wpływać na ogólną wydajność.

Chcę jednak zacząć od bardzo zwyczajnego pomiaru - szybkości uruchamiania systemu operacyjnego Microsoft Windows 7 Ultimate x64. Diagram przedstawia czas od naciśnięcia przycisku zasilania do momentu, w którym system zaczyna reagować na działania użytkownika.

Różnica między systemami z powolną mechaniką twardy dysk a z dyskiem półprzewodnikowym osiąga 30%. Jednocześnie zwiększenie ilości pamięci wpływa bardzo nieznacznie na szybkość ładowania systemu operacyjnego.

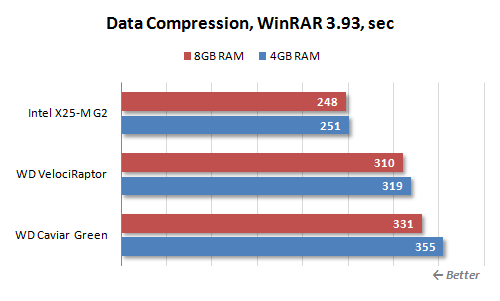

Oczywiście wybór dysku twardego może znacznie wpłynąć na szybkość pracy, gdy dane pobierane są bezpośrednio z nośnika, a nie z pamięci. Dobrym przykładem takiego zadania jest archiwizacja. Jak wiemy, szybkość kompresji danych w WinRAR zależy zasadniczo od szybkości procesora i podsystemu pamięci. Okazuje się, że wydajność podsystemu dyskowego może mieć nie mniejszy wpływ.

Co ciekawe, spory wpływ ma też wydajność i ilość pamięci RAM. Jednak nie zawsze się pojawia, a tylko wtedy, gdy podsystem dyskowy nie ma wystarczającej szybkości. Wydaje się więc, że dodanie dodatkowych gigabajtów pamięci w celu zwiększenia wydajności dysków twardych ma sens tylko wtedy, gdy same nie należą do produktywnych.

Podobne do archiwizacji i procesu transkodowania plików audio do formatu mp3. Należy jednak pamiętać, że wiele narzędzi do transkodowania działa tylko w jednym lub dwóch wątkach obliczeniowych. W tym przypadku prędkość nawet najwolniejszego dysku twardego jest więcej niż wystarczająca, aby zapewnić takiemu narzędziu niezbędne dane. Do testów wybraliśmy konwerter dPoweramp, który efektywnie wykorzystuje wszystkie dostępne rdzenie procesora, jednocześnie transkodując kilka plików – po jednym dla każdego rdzenia. I w tym przypadku prędkość dysku twardego zaczyna odgrywać bardzo istotną rolę.

Wielowątkowy zapis danych - słabość Western Digital Caviar Green i oczywiście nie zdał tego testu. Western Digital VelociRaptor i Intel SSD były znacznie szybsze, ale zauważalna była 15-procentowa różnica między ich prędkościami. Nawiasem mówiąc, w tym teście ilość pamięci RAM również odgrywa pozytywną rolę, ale oczywiście nie trzeba znowu mówić, że 8 GB pamięci może stać się alternatywą dla szybkiego dysku.

Innym częstym zadaniem związanym z przetwarzaniem przesyłanych w czasie rzeczywistym danych jest transkodowanie wideo. Do celów testowych użyliśmy narzędzia HandBrake opartego na x.264 do transkodowania wideo 1080p MPEG-2 do formatu H.264.

I tutaj nie ma zależności ani od szybkości dysków, ani od ilości pamięci wideo. Jest to jednak zrozumiałe – moc szybkiego procesora Core i7-870 nie wystarczy do transkodowania plików wideo szybciej, niż są one odczytywane nawet z najwolniejszego dysku.

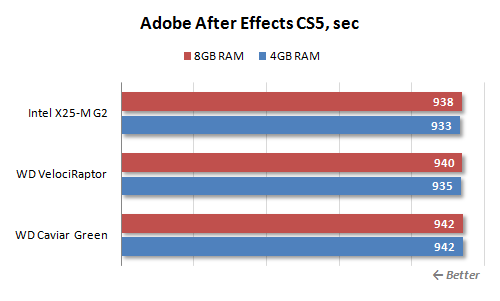

Co więcej, podobny obraz obserwuje się nie tylko przy prostym transkodowaniu, ale także przy stosowaniu efektów do wideo, na przykład w Adobe Po efekty.

Prawdopodobnie, aby zobaczyć wpływ wydajności podsystemu dyskowego na szybkość przetwarzania danych wideo o wysokiej rozdzielczości, warto poczekać na wzrost szybkości procesorów.

Kolejną rzeczą jest edycja obrazu w programie Adobe Photoshop. Oczywiście zwykłe zdjęcia z aparatów cyfrowych mieszczą się więcej niż 4 GB. Jednak osobliwością tego popularnego edytora graficznego jest to, że podczas wykonywania operacji na obrazach zapisuje historię działań, a tutaj 4 GB może nie wystarczyć. Właściwie, ze standardowymi ustawieniami - zapisując ostatnie 20 stanów - edytor graficzny zaczyna aktywnie korzystać z dysku twardego, co powoduje uzależnienie jego wydajności od szybkości podsystemu dyskowego.

Jak widać, szybkość naszego scenariusza testowego, czyli ulepszonego Retouch Artists Photoshop Speed Test, który obejmuje typowe przetwarzanie czterech 10-megapikselowych zdjęć wykonanych aparatem cyfrowym, zależy bardziej niż silnie od szybkości dysku. . Różnica w wynikach uzyskanych na Western Digital Caviar Green i Intel X25-M G2 jest nawet dwukrotna. Ale również najlepszy efekt można osiągnąć poprzez zwiększenie pamięci RAM. Jak wynika z wyników, 8 GB pamięci RAM w ogóle eliminuje konieczność buforowania danych na dysku, co skutkuje ogromnym wzrostem wydajności.

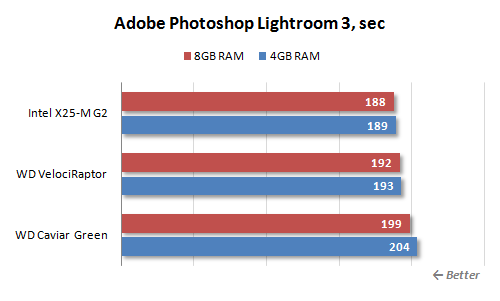

Jeśli jednak mówimy ogólnie o pracy z obrazami, to Photoshop jest bardzo nietypowym przypadkiem. W końcu obżarstwo w stosunku do pamięci odnosi się do cech tego konkretnego edytora. Na przykład podczas przetwarzania wsadowego podobnych obrazów w programie Adobe Photoshop Lightroom wpływ wielkości pamięci RAM na szybkość pracy jest minimalny.

A wybór dysku twardego może spowodować efekt, który nie przekracza 10%.

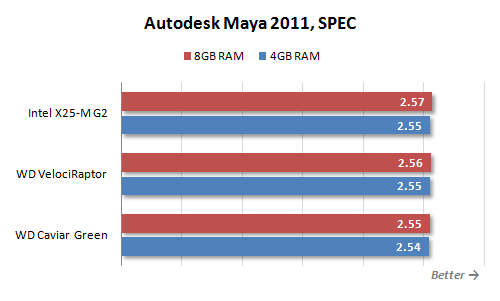

Interesujące wydało nam się sprawdzenie, czy istnieje zależność od dysku twardego i ilości pamięci w nowoczesnych pakietach do wizualizacji 3D. Jako przykład wybrano Autodesk Maya, ponieważ istnieje rzeczywisty test SPEC dla tego pakietu, który działa z raczej „ciężkimi” modelami.

Jednak, jak pokazała praktyka, 4 GB pamięci dla Mayi w zupełności wystarczy, a zależność od szybkości podsystemu dyskowego jest bliska zeru.

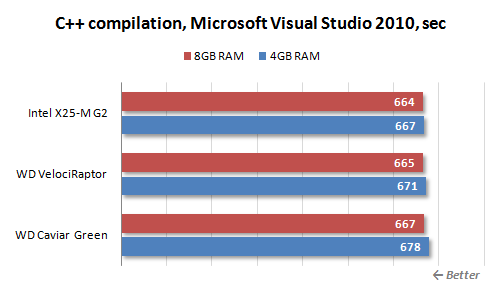

Ponadto mieliśmy nadzieję zobaczyć pozytywny wpływ szybszych dysków i większej ilości pamięci RAM na szybkość kompilacji dużych projektów.

Jednak w rzeczywistości zależność ta okazała się nieznaczna. Chociaż podczas kompilacji system bardzo aktywnie „szeleści” dyskiem, nie można osiągnąć znacznego przyspieszenia tego procesu poprzez zmianę nośnika pamięci lub zwiększenie ilości pamięci RAM.

Testowanie w grach 3D

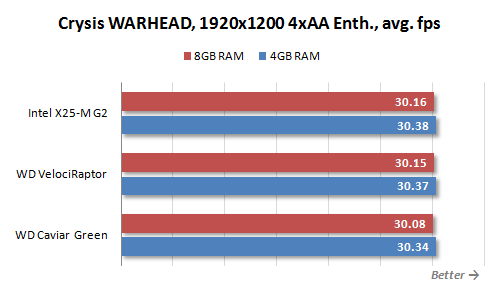

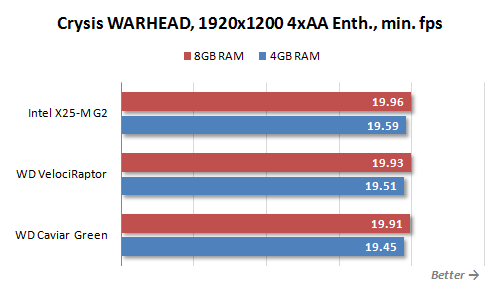

Jeśli chodzi o gry, od razu możemy powiedzieć niemal to samo, co o pracy w innych typach aplikacji. Mianowicie właściciele szybszego podsystemu dyskowego mają przynajmniej tę zaletę, że ich komputery uruchamiają się znacznie szybciej. programy do gier, nowe poziomy i zapisane stany. I tutaj komentarz jest zbędny – to dość oczywiste zjawisko. My, podobnie jak poprzednio, postaramy się dowiedzieć, czy szybkość dysku twardego i ilość pamięci RAM bezpośrednio wpływają na rozgrywkę - na obserwowaną liczbę klatek na sekundę.

Przede wszystkim warto zauważyć, że przygotowując ten artykuł wypróbowaliśmy wiele różnych gier, ale nigdy nie spotkaliśmy takiej, która nie miałaby wystarczającej ilości 4 GB pamięci. Innymi słowy, prawie każda nowoczesna aplikacja do gier (jeśli nie wszystkie) nie „przejdzie do wymiany” w typowym systemie ze standardową ilością pamięci RAM. Mówiąc w liczbach, obraz prawie zawsze wygląda następująco.

Jak widać, praktycznie nie ma zależności od szybkości dysku twardego ani ilości pamięci. Co więcej, zarówno średnia liczba klatek na sekundę, jak i wartość minimalna okazują się niemal stałe, co świadczy o tym, że wszystkie potrzebne dane idealnie mieszczą się w pamięci, a podczas przechodzenia poziomu gry nie dochodzi do nieoczekiwanego ładowania informacji.

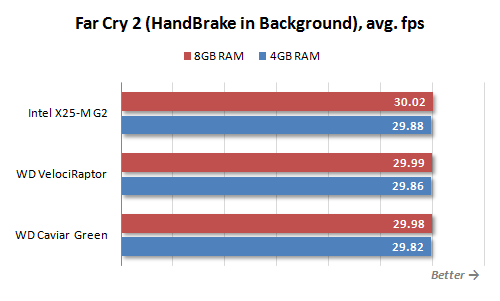

Jednak przy tym wszystkim zalety szybszego dysku i większej ilości pamięci nadal mogą być odczuwalne w grach. Aby to zrobić, wystarczy nieco zmienić model korzystania z komputera. Innymi słowy, jeśli uznamy system za prostą konsolę do gier, to jak widzieliśmy, nie ma pilnej potrzeby szybkiego dysku i 8 GB pamięci RAM. Ale jeśli gry nie są uruchamiane w odizolowanym środowisku, ale do wielu celów komputer osobisty nie tak rzadkie, równolegle z innymi procesami wymagającymi dużych zasobów, sytuacja może się radykalnie zmienić. Co więcej, zmiany jakościowe obserwuje się nawet wtedy, gdy gra z procesem w tle idealnie pasuje do dostępnej pamięci RAM.

Na przykład przetestowaliśmy prędkość w Far cry 2 uruchomione podczas transkodowania wideo HD w tle w HandBrake. Oba te programy wraz z systemem operacyjnym nie wyszły poza 4 GB, ale więcej szybki dysk lub dodatkowa pamięć umożliwiły znaczne zwiększenie minimalnej prędkości.

Chociaż średnia ważona wydajność pozostaje mniej więcej taka sama, aktywność dysku w tle może powodować niepożądane zacinanie się gry działającej na pierwszym planie. Aby zmniejszyć ten negatywny efekt, wymagany jest szybszy dysk i więcej pamięci RAM.

Pomimo całej nieoczywistości postawionego w artykule pytania, przeprowadzone badania pozwalają na sformułowanie całkowicie jednoznacznego wniosku co do preferowanych kierunków modernizacji. Jak wykazało sprawdzenie w rzeczywistych aplikacjach i złożone testy, takie aplikacje dające największy efekt można dać przy użyciu dużej szybkości Dysk SSD, zamiast zwiększać ilość pamięci RAM powyżej 4 GB.

Banalna wielkość pamięci wynosząca 4 GB wystarcza dziś w niemal wszystkich typowych sytuacjach, a jak wykazały testy, przekroczenie tej ilości nie przynosi widocznego wzrostu wydajności. Mały pozytywny efekt dodatkowa pamięć zauważalne tylko wtedy, gdy system używa bardzo wolnego dysku twardego. Technologia SuperFetch, która wykorzystuje dodatkową pamięć do proaktywnego buforowania danych, w tym przypadku może zwiększyć szybkość reakcji systemu. Jednak inwestycja wymagana do zwiększenia ilości pamięci jest znacznie bardziej logiczna, aby przekierować ją na ulepszenie systemu dyskowego - wynik będzie znacznie bardziej znaczący.

Warto zaznaczyć, że system operacyjny Windows 7, a zwłaszcza jego 64-bitowa wersja, otrzymał bardzo zaawansowanego menedżera pamięci, który pozwala bardzo efektywnie wykorzystać dostępne dla systemu gigabajty. W rezultacie przy przełączaniu z Windows Vista na bardziej nowoczesnym systemie potrzeba zainstalowania więcej niż 4 GB pamięci RAM jest jeszcze mniejsza niż wcześniej. I nawet jeśli w Menedżerze zadań zobaczysz, że prawie cała wolna pamięć fizyczna jest wyczerpana, najprawdopodobniej nie wynika to z jej braku, ale wręcz przeciwnie, z jej racjonalnego wykorzystania do buforowania danych z dysku.

Oparty na zastosowaniu dysków półprzewodnikowych szybki podsystem dyskowy, w przeciwieństwie do dodatkowej pamięci, wygra w każdym przypadku. Wszak wzrasta nie tylko szybkość pracy w aplikacjach, które pracują z danymi ładowanymi z dysku. Poprawia się również ogólne wrażenie platformy: ogólnie lepiej reaguje ona na działania użytkowników. System operacyjny i programy otwierają się szybciej, pliki robocze ładują się szybciej. Wpływ tych czynników na produktywność użytkowników jest oczywiście niewielki. Ale nastrój emocjonalny, dzięki pomocnej gotowości komputera do wykonywania wielu operacji w ciągu kilku chwil, co wcześniej powodowało irytujące szelest dysków, może znacznie się poprawić.

Jednocześnie należy zrozumieć, że aktualizacja podsystemu dyskowego nadal nie jest rozwiązaniem całkowicie uniwersalnym. Istnieje wiele konkretnych przypadków, w których 8 GB pamięci może być bardziej przydatne niż szybki dysk. Na przykład istnieją aplikacje (w naszych testach okazało się, że jest to Adobe Photoshop), które mogą łatwo załadować swoje dane i 8 GB pamięci. Podczas pracy przydatne są duże ilości pamięci wirtualne maszyny, na przykład z VMware i Oracle VM Virtual Box. W szczególności, jeśli dostaną do dyspozycji wystarczającą ilość pamięci RAM, to użytkownik nie będzie musiał zatrzymywać jednej maszyny, aby uruchomić inną – wystarczy po prostu przełączać się między nimi. Wszystkie takie przypadki dotyczą jednak bardziej profesjonalnego użytkowania komputera, a profesjonaliści zwykle nie mają pytań o bardziej racjonalny upgrade – wszystko wiedzą od początku i na pewno.

Więc nasza rekomendacja będzie następująca: jeśli naprawdę masz pytanie, na którym upgrade powinieneś skoncentrować swoje wysiłki, to radzimy pomyśleć o ulepszeniu podsystemu dyskowego i zakupie dysków SSD. Jednak w przypadku, gdy już odczuwasz brak pamięci RAM i bardzo cierpisz z powodu opóźnień związanych z dostępem systemu operacyjnego do pliku wymiany, powinieneś skupić się przede wszystkim na zwiększeniu ilości pamięci RAM.

Inne materiały na ten temat

Jaka pamięć jest dobra dla Phenom II X6?

Przegląd dziewięciu dysków SSD firmy Corsair

Dziesięć dysków SSD OCZ

Witam wszystkich Dysk twardy to po prostu urządzenie, na którym znajduje się wszystko, co masz na komputerze, to wszystko, co tam jest. Oznacza to, że jest to urządzenie do przechowywania danych, wszystko jest na nim przechowywane, cóż, wszystko, co masz, to programy, gry, muzyka, filmy i inne pliki. Dlatego jeśli jest pokryty miedzianą misą, stracisz to wszystko. Jestem za czym Dysk twardy to jest bardzo ważne urządzenie i należy obchodzić się z nim ostrożnie, aby nie narażać komputera na jakiekolwiek wstrząsy, że tak powiem.

Witam wszystkich Dysk twardy to po prostu urządzenie, na którym znajduje się wszystko, co masz na komputerze, to wszystko, co tam jest. Oznacza to, że jest to urządzenie do przechowywania danych, wszystko jest na nim przechowywane, cóż, wszystko, co masz, to programy, gry, muzyka, filmy i inne pliki. Dlatego jeśli jest pokryty miedzianą misą, stracisz to wszystko. Jestem za czym Dysk twardy to jest bardzo ważne urządzenie i należy obchodzić się z nim ostrożnie, aby nie narażać komputera na jakiekolwiek wstrząsy, że tak powiem.

Powiem ci, jak dowiedzieć się, jaki dysk twardy masz w komputerze, a także powiem ci, jakie niezawodne dyski i jak sprawdzić temperaturę!

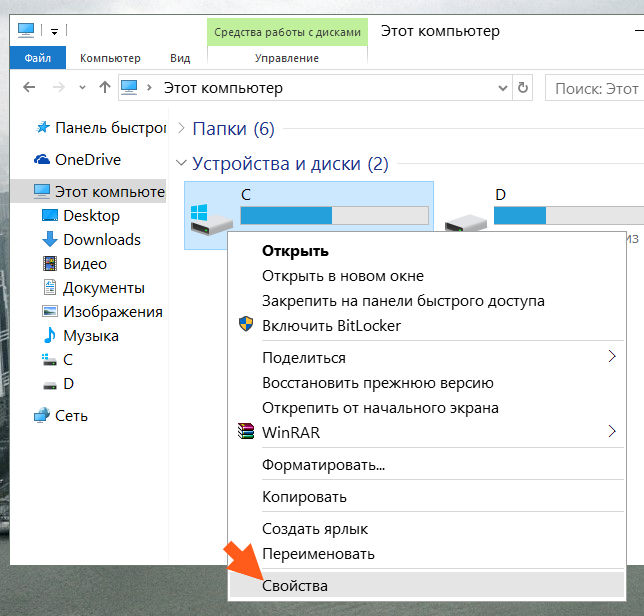

Ale ogólnie zacząłem pisać coś o czymś innym, chciałem ci pokazać, jak dowiedzieć się, jaki masz dysk twardy. Pokażę na przykładzie Windowsa 10, ale w innych Windowsach wszystko będzie tak samo. Więc najpierw musisz otworzyć okno Mój komputer, jeśli w Windows 7 jest to łatwe, cóż, jest taki element w Start, to w Windows 10 nie pamiętam, jak to zrobić. Po prostu od razu umieściłem skróty na dyskach lokalnych w Start. Ale jest sztuczka, spójrz, przytrzymaj Win + R i wpisz następujące polecenie w oknie:

plik eksploratora://

I kliknij OK. Następnie otworzy się okno Mój komputer, działa, sprawdziłem. Świetnie, więc tutaj mamy otwarte okno, kliknij tam kliknij prawym przyciskiem myszy na dowolnym dysku i wybierz Właściwości:

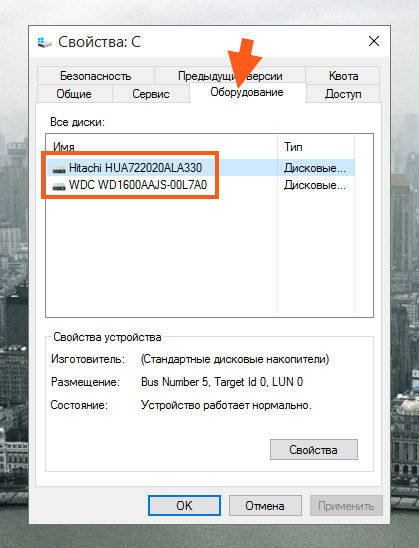

Otworzy się okno, przejdź do zakładki Sprzęt i zostaną tam wymienione wszystkie posiadane dyski fizyczne. Na przykład mam tutaj dwa, są to WD i Hitachi:

Dokładny model dysku jest wskazany tutaj, dokładnie model. Jeśli chcesz dowiedzieć się, ile miejsca jest na dysku, ile jest wolnego, musisz przytrzymać Win + R, wprowadź polecenie w oknie:

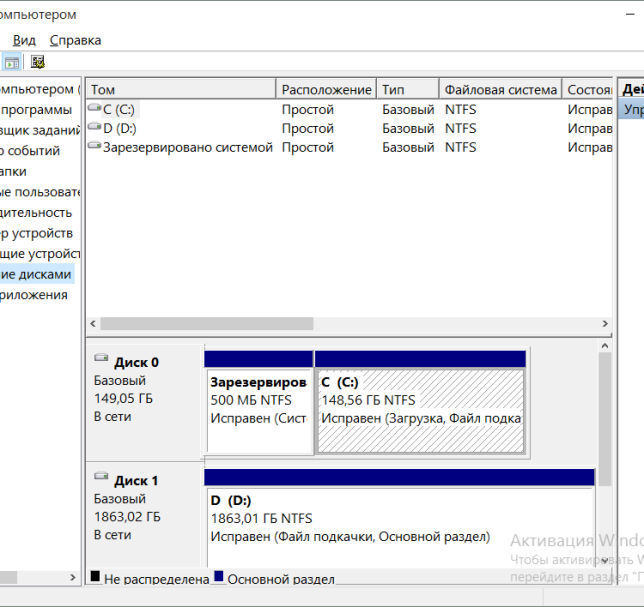

I kliknij OK. Otworzy się okno, w którym znajduje się taki element, jak Zarządzanie dyskami, więc wybieramy go:

I zobaczysz takie informacje:

Od razu powiem, że nie ma tu nic skomplikowanego, Tobie może się to tylko wydawać skomplikowane. Spójrz, tam na dole napisałem Dysk 0, Dysk 1, to tylko dwa dyski i tak się nazywają w systemie Windows. Naprzeciwko każdego dysku możesz zobaczyć, jakie są partycje i jaki jest fizyczny wolumin całego dysku:

Cóż, wydaje się jasne, mam nadzieję. Ponieważ piszę o dysku twardym, odpowiem jeszcze na dwa pytania, które często pojawiają się wśród początkujących użytkowników komputerów.

Który dysk twardy jest najbardziej niezawodny? Niezawodny dysk ta koncepcja jest względna, wszystko zależy od tego, jak będzie używana. Jednak najbardziej niezawodny dyski twarde na świecie są to oczywiście serwerownie, ale są one: hałaśliwe, drogie i często średniej wielkości lub mniejszej. Nie nadają się do domu, ale są w stanie wytrzymać długi ładunek i nic im się nie stanie. Potem przychodzą dyski domowej roboty, też są niezawodne, ale moim zdaniem najbardziej niezawodnym producentem jest oczywiście Western Digital (WD): niezależnie od tego, ile mam dysków tego producenta, nigdy się nie zepsuły, pomimo tego, że wszystko brałem z drugiej ręki. Więc moim wyborem jest WD

Ale ostatnio trafiłem na dysk w dobrej cenie, ale prawda jest taka, że to już nie WD, tylko Hitachi. Już trzeci miesiąc pracuje na okrągło i wydaje się, że wszystko jest w porządku. Ale nadal najbardziej niezawodny sztywny dla mnie dyski pozostaną pod marką WD, ale super-duper niezawodne dyski to linia dysków WD VelociRaptor. Są to nie tylko najbardziej niezawodne, ale także superszybkie, nawiasem mówiąc, naprawdę superszybkie! Ale cena jaką mają jest trochę kosmiczna. Jeśli chodzi o zwykłe dyski, to polecam serię WD Black, tę napędy prędkości, są nawet dwa procesory i jak na tę cenę są już normalne...

Nawiasem mówiąc, oto jak wygląda dysk twardy VelociRaptor:

Jak widać, tutaj dysk jest właściwie mały, formatu 2,5, a wszystko inne to już radiator, który chłodzi dysk. Cały sens dysku polega na tym, że działa z dużymi prędkościami, podobnie jak dyski serwerowe - z prędkością 10 000 obr./min. Ale cena jest za wysoka...

Chociaż linia WD Blue również nie jest zła, zwykłe wysokiej jakości koła i cena nie są wysokie. Generalnie przekonajcie się sami, ale myślę, że wielu zgodzi się ze mną, że WD jest najbardziej niezawodny..

Jaka powinna być temperatura dysku twardego? Ale nie wiem o tym pytaniu dla ciebie, ale dla mnie jest to dotkliwe. Cóż, to jest dla mnie ważne. Chodzi o to, że dysk twardy nie lubi wysokich temperatur. Maksymalna temperatura dysku twardego wynosi 40 stopni i nie jest to zbyt dobra temperatura, idealna to 30-35. Wtedy będzie działać przez długi czas. Da radę w wieku 45 lat, ale uwierz mi, nie będzie zbyt dobry. Mimo wszystko jest mu gorąco.

Zewnętrzny dysk twardy: gdy nie ma dużo pamięci

Grube i cienkie

Obecnie zewnętrzne dyski twarde występują w dwóch głównych typach lub, jak się je również nazywa, formatach - 3,5- i 2,5-calowych, w zależności od średnicy płyty samego dysku, co częściowo determinuje różne rozmiary urządzeń. Ostatnio pojawiły się również 1,8-calowe zewnętrzne dyski twarde, ale takich modeli jest bardzo mało, prawie nie różnią się one od 2,5-calowych, z wyjątkiem nieco mniejszego rozmiaru i pojemności oraz nieco wyższej ceny za gigabajt, dlatego w celu żeby nie zmylić czytelnika, będziemy je oznaczać w grupie technologii 2,5-calowych.

Dla tych, którzy są przynajmniej trochę zorientowani w dyskach twardych, łatwo zgadnąć, że konstrukcja dysku twardego dla komputerów stacjonarnych jest brana za podstawę dla tego pierwszego, a ten drugi odziedziczył swój rozmiar po dyski twarde na laptopach.

Inne kluczowe wskaźniki przekazano im od ich „przodków”, przede wszystkim prędkość obrotowa wrzeciona, która zwykle jest ustawiona na 7200 dla 3,5-calowych i 5400 lub 5900 obr./min dla 2,5-calowych. Chociaż nie można tego nazwać ścisłą zasadą: niektóre modele 3,5-calowych dysków twardych, zwłaszcza te o dużej pojemności, mają prędkość 5900, a nawet 5400 obr./min. Od tych tysięcy na minutę zależy prędkość dysku twardego i szybkość pracy z interfejsem.

Kolejnym mniej ważnym, ale wciąż znaczącym parametrem technicznym jest bufor pamięci, od którego w pewnym stopniu zależy szybkość przesyłania danych. W przypadku 3,5-calowych dysków twardych zwykle mieści się w przedziale 16-32 MB, ale w stosunkowo drogich modelach może to być również 64 MB (w oparciu o koszt każdego GB pamięci głównej). W przypadku 2,5-calowego formatu typowe są skromne bufory 8-16 MB, ale, jak zapewne się domyślasz, 3,5-calowe występują również w takich modelach, z reguły o niskiej prędkości wrzeciona.

Od zewnętrzny dysk twardy pełne relacje z wewnętrznymi, mają taką samą ilość całkowitej pamięci, jak ich odpowiedniki na komputerach stacjonarnych i laptopach. „Fatties” w większości dzisiaj – od 500 do 1500 GB, choć zdarzają się mniejsze modele i, co najważniejsze, większa pojemność, 2000 GB, czyli dwa terabajty (chyba nie wszyscy z Was są jeszcze przyzwyczajeni do tego słowa?). Ich smuklejsze odpowiedniki mogą pomieścić nie więcej niż 1000 GB, zaczynając od 160…

Typowy „ciasto” 2,5-calowy dysk twardy z

Różne objętości wpływają również na różnice w wadze. Jeśli 3,5-calowe zewnętrzne dyski twarde ważą plus minus kilogram, to ich mniejsi bracia mogą pochwalić się, że ważą zaledwie 150-200 gramów. Oznacza to, że te ostatnie z łatwością zmieszczą się w kieszeni marynarki, a do transportu ich cięższych i większych krewnych potrzebna jest jakaś torba.

Dobrze odżywione dyski twarde naturalnie pobierają dużo energii, dlatego wyposażone są we własne zasilanie i są uzależnione od połączenia sieciowego, natomiast cienkie wystarczy podłączyć do komputera, aby były z niego zasilane kablem USB, co jest dlaczego te dyski twarde są często wyposażone w przewody w kształcie litery Y do natychmiastowego podłączenia do dwóch wejść USB.

Dlaczego rozmiar nie ma znaczenia

Ponieważ nazywane są tymi samymi słowami, zewnętrzne dyski twarde, oprócz podstaw konstrukcji i ogólnych zasad działania, mają również oczywiste podobieństwa. Przede wszystkim oba są podłączone do komputera przez USB 2.0, co czyni je kompatybilnymi z niemal każdą maszyną. I zapewnia, jak na współczesne standardy, bardzo przyzwoitą szybkość przesyłania danych, ograniczoną jedynie wskazanymi wcześniej parametrami.

To prawda, że wśród 3,5-calowych zewnętrznych dysków twardych są modele z interfejs eSATA, która umożliwia podłączenie do komputera, oprócz USB, w taki sam sposób, jak wewnętrzne dyski twarde - przez SATA. Pozwala to na przesyłanie informacji z prędkością do 80 Mb/s, podczas gdy tradycyjnym dla nich kanałem nie przepuszcza się więcej niż 35 Mb/s. Taki dysk twardy za 300-500 rubli. droższe niż zwykle.

Ale niektóre modele 2,5-calowych dysków twardych, za pomocą różnych sztuczek, takich jak funkcja USB Turbo Speed stosowana w produktach jednego z liderów rynku Verbatim, mogą zwiększyć prędkość transferu o około jedną czwartą. Ich cena z tego powodu również wzrasta o sto lub dwa.

Zarówno te, jak i inne zewnętrzne dyski twarde są technicznie odpowiednie do tych samych operacji. Niezależnie od współczynnika kształtu, są one wyposażone systemy plików albo stary FAT32, który zdarza się coraz rzadziej, albo nowy NTFS, który jest typowy dla większości dysków twardych. Ten ostatni ma istotne zalety w stosunku do swojego poprzednika, przede wszystkim ze względu na możliwość korzystania z wbudowanego funkcja okien szyfrowanie danych i możliwość przechowywania plików większych niż 4 GB, w których FAT32 jest bezsilny. Ale FAT32 ma również swoje własne hobby, które jak dotąd zapewnia jego przetrwanie: w przeciwieństwie do NTFS jest kompatybilny ze starszymi systemami operacyjnymi Windows (98 i ME) oraz odtwarzaczami DVD z interfejsem USB.

Co dziwne, dyski twarde obu formatów są prawie tak samo ciche, różnica jest ledwo wyczuwalna dla ucha, chociaż oczywiście nie jest na korzyść 3,5-calowych dysków twardych. Tylko niektóre modele tych ostatnich, wyposażone we własny wentylator, potrafią sygnalizować swoją pracę dość głośnym dźwiękiem. Ale też nagrzewają się najmniej, nie więcej niż 40°C, podczas gdy ich odpowiedniki bez aktywnego chłodzenia podczas intensywnej pracy potrafią osiągnąć temperaturę 60°C. 2,5-calowe dyski twarde nie wymagają żadnych specjalnych chłodnic, ponieważ generują stosunkowo mało ciepła, maksymalnie do 40-45°C.

Kwestia wyboru

Z powyższego widać, że zewnętrzne dyski twarde są idealne do przechowywania dużych ilości informacji. Pod tym względem ani dyski flash, ani DVD, ani nawet BD, aż do wielokrotnego zapisu, nie mogą z nimi konkurować.

Powodem jest nie tylko to, że jeden jest średniej pojemności twardy zewnętrzny Płyta zastąpi całą półkę płyt DVD, a na najbardziej obszernej znajdą się informacje z co najmniej kilkunastu najfajniejszych czterowarstwowych płyt BD. Cena jednego gigabajta pamięci dla najbardziej pojemnych zewnętrznych dysków twardych 3,5 cala jest niższa niż dla DVD, nie mówiąc już o DVD-RW.

To prawda, że 2,5-calowy format jest pod coraz większą presją konkurencyjną ze strony pamięci flash, która ma szereg zalet (niskie zużycie energii, całkowita bezgłośność, wyjątkowo wysoka wytrzymałość mechaniczna), ale jak dotąd nadal ma decydujący atut - niezrównaną niższa cena za gigabajt.

Jednocześnie należy pamiętać, że w przypadku 2,5-calowych dysków twardych o porównywalnej pojemności koszt jednego gigabajta jest o około 20% wyższy niż w przypadku „grubasów”. A gigabajt najbardziej pojemnego 3,5-calowego jest o około 40% tańszy niż najbardziej pojemny 2,5-calowy.

Różnica w cenie w połączeniu z doskonałymi wymiarami i wagą ułatwia określenie, który rozmiar zewnętrznego dysku twardego najlepiej nadaje się do czego. Technologia 3,5 cala to idealne rozwiązanie do przechowywania kopii zapasowej z dysku twardego komputera lub komputerów w domu, umieszczania na nim bibliotek zdjęć i filmów oraz swojej kolekcji muzycznej. 2,5-calowe dyski twarde najlepiej nadają się do przesyłania dużych ilości danych; idealne rozwiązanie dla tych, którzy często muszą podróżować po okolicy i chcą mieć pod ręką "na wszelki wypadek strażaka" kopia zapasowa z dysku twardego laptopa, biblioteki filmów podróżniczych itp. Inną opcją jest to, że niektóre szczególnie ostrożne osoby trzymają w kieszeni 2,5-calowy zewnętrzny dysk twardy z najważniejszymi informacjami, których nie ma nawet w laptopie, zmniejszając w ten sposób ryzyko utraty danych w przypadku kradzieży laptopa.

Co jest dla Ciebie odpowiednie? Możliwe, że oba typy będą przydatne. Cokolwiek wybierzesz, pamiętaj, że pojemność dysku twardego nigdy nie jest za duża. Ta reguła działa w przypadku zewnętrznych dysków twardych w dokładnie taki sam sposób, jak w przypadku dysków wewnętrznych. Przed zakupem oszacuj, ile gigabajtów potrzebujesz teraz i możesz wziąć dysk twardy co najmniej półtora raza więcej. Ponieważ w tym przypadku każdy gigabajt będzie kosztować znacznie mniej. A praktyka pokazuje, że w tym przypadku rzeczywiście „apetyt przychodzi wraz z jedzeniem”: za rok, maksymalnie za dwa, pochwalisz się za dalekowzroczność. Ponieważ plików jest znacznie więcej, średni wolumen wzrósł ze względu na wzrost jakości przechowywanych materiałów audio, fotograficznych i wideo, pojawiły się nowe hobby…

Eleganckie rozwiązanie na 8 terabajtów

Ci, którzy nie są usatysfakcjonowani opcjami projektowymi dysków zewnętrznych oferowanych na rynku, zwłaszcza raczej prostych 3,5-calowych dysków twardych (lub z innego powodu), mogą kupić osobne pudełko na zewnętrzny dysk twardy i włóż do niego zwykły dysk twardy, który jest używany w komputerach. Ta opcja jest szczególnie dobra, jeśli jeden dysk 3,5 cala to dla Ciebie za mało i chcesz mieć kilka (lub nawet więcej) w jednym specjalnie do tego stworzonym pojemniku (często drugi jest kupowany później, gdy pierwszy jest już po brzegi, a nowe dyski twarde stały się jeszcze bardziej pojemne i tańsze).

Pozostaje tylko dodać, że główni producenci zewnętrznych dysków twardych są tacy sami jak wewnętrznych -, Technology, GST, Electronics,.

Dzisiaj powiem ci, jak sprawdzić liczbę dysków twardych zainstalowanych na naszym komputerze. Te informacje będą nam przydatne, gdy będziemy rozmawiać o rzeczach takich jak kopia zapasowa dane.

Jak wiesz, na komputerze często znajduje się wiele woluminów. Na przykład C i D. Ale w większości przypadków są to dwa dyski logiczne, na których oznaczony jest jedyny dysk fizyczny zainstalowany na komputerze.

Ale zdarza się również, że komputer ma zainstalowanych kilka dysków fizycznych, z których każdy można oznaczyć jedną literą lub z kolei podzielić na kilka dysków lokalnych.

Wydawałoby się, co to za różnica, dysk logiczny czy fizyczny. Wszystko jest takie samo dla systemu.

Dla systemu oczywiście tak, ale nie dla ciebie i twojego sprzętu.

Na przykład masz komputer, który ma dwa dyski - C i D (może być ich znacznie więcej, nie jest to konieczne). Jeśli masz zainstalowany jeden dysk fizyczny podzielony na dwa woluminy logiczne, to w przypadku awarii dysku fizycznego wszystkie woluminy logiczne, na które podzielony jest dysk, staną się niedostępne.

Jeśli tomy C i D są oddzielne dyski fizyczne, to awaria jednego woluminu nie pociąga za sobą uszkodzenia drugiego.

Jak więc określić liczbę dysków twardych w komputerze?

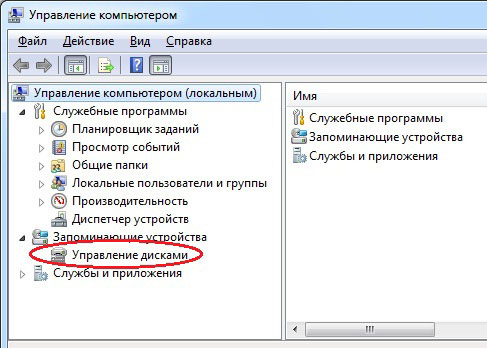

Wszystko jest bardzo proste. Kliknij „Start” i kliknij prawym przyciskiem myszy „Komputer”. W pojawiającym się menu kontekstowe wybierz „Zarządzanie”.

Otworzy się następujące okno:

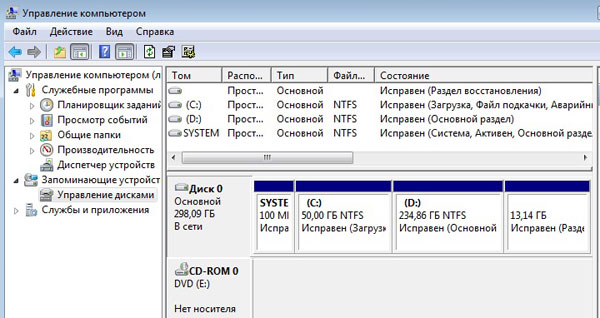

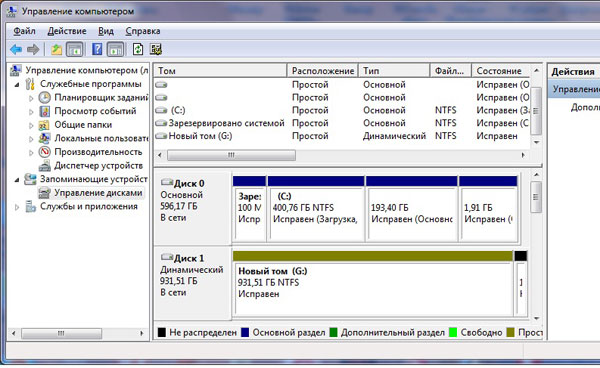

Tutaj musisz wybrać sekcję „Zarządzanie dyskami”. Na wyświetlaczu pojawią się informacje o dyskach fizycznych i woluminach logicznych, na których są one zaznaczone. Na poniższej ilustracji przedstawiono przykład jednego dysku twardego podzielonego na dwa dyski logiczne. Istnieją również dwie ukryte sekcje przeznaczone na potrzeby systemowe.

A tutaj widzimy jednocześnie dwa dyski twarde:

Teraz wiesz, jak określić liczbę dysków twardych na komputerze. Jeśli jesteś gotowy, aby przejść dalej, śledź publikacje.

Możesz wysłać swoje pytania do rubryki ” Bezpłatna pomoc"pod adresem: [e-mail chroniony] strona internetowa. Napisz „Bezpłatna pomoc” w temacie wiadomości e-mail.

Dysk twardy jest jednym z głównych elementów komputera. W końcu to na nim przechowywana jest większość danych, zarówno użytkownika, jak i systemu. W tym artykule porozmawiamy o tym, jak dowiedzieć się, który dysk twardy znajduje się na twoim komputerze i jakie ma cechy.

Numer metody 1. Właściwości dysku.

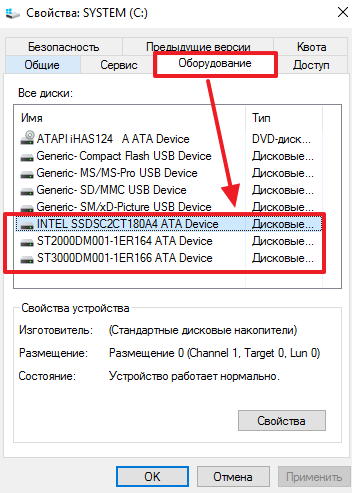

Najłatwiejszym sposobem sprawdzenia, który dysk twardy znajduje się w komputerze, jest skorzystanie z wbudowanych narzędzi system operacyjny Okna. Aby to zrobić, otwórz okno „”, kliknij prawym przyciskiem myszy dowolny dysk twardy i wybierz element menu „Właściwości”.

Następnie otworzy się przed tobą okno „Właściwości dysku”. Tutaj, w zakładce „Sprzęt”, znajduje się lista wszystkich dysków podłączonych do komputera.

Lista ta obejmuje między innymi dyski twarde. Jedynym minusem jest to, że nazwy dysków twardych są prezentowane w skróconej formie.

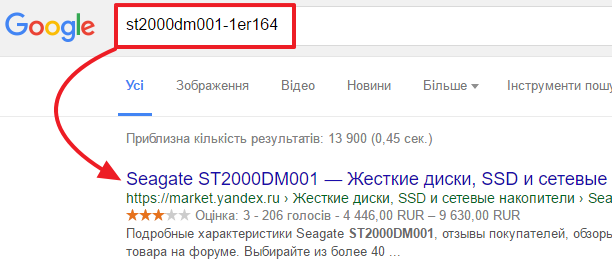

Aby uzyskać więcej informacji o dysku twardym, wystarczy wpisać jego skróconą nazwę w dowolnym miejscu wyszukiwarka. I możesz łatwo znaleźć stronę opisującą wszystkie jego cechy.

Metoda numer 2. Program HDDlife Professional.

Jeśli chcesz nie tylko dowiedzieć się, jaki dysk twardy znajduje się na twoim komputerze, ale także uzyskać wszystkie możliwe informacje na jego temat, możesz do tego użyć programu HDDlife Professional. Ten program jest płatny, ale wersja Trial wystarczy, aby wyświetlić informacje o jednym dysku twardym.

Jak widać na powyższym zrzucie ekranu, HDDlife dostarcza informacji o modelu dysku twardego, producencie dysku twardego, kondycji dysku twardego, temperaturze i dyskach logicznych.

Program HDDlife Professional można pobrać. Możesz także pobrać oprogramowanie HDDlife for Notebooks (wersja dla notebooków) i SSD Life Professional (wersja dla Dyski SSD).

Numer metody 3. Program CrystalDiskInfo.

CrystalDiskInfo - można uznać za darmową alternatywę dla HDDlife Professional. CrystalDiskInfo wyświetla informacje o wszystkich dyski twarde które są na komputerze. Spowoduje to wyświetlenie nazwy modelu, wersji oprogramowania układowego, numer seryjny, używany interfejs, litera woluminu, prędkość obrotowa, liczba uruchomień, całkowity czas pracy, temperatura, dane systemu SMART i inne informacje.

W przypadku dysków SSD CrystalDiskInfo może wyświetlać dodatkowe informacje. Na przykład ilość odczytanych i zapisanych danych przez cały okres pracy dysku. Możesz pobrać program.